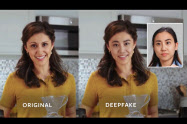

AI駆使し本物そっくり 「ディープフェイク」の脅威

人工知能(AI)の最新技術を使って、本人とそっくりのニセ映像を作る「ディープフェイク」の被害が広がる兆しを見せています。映像だけでなく音声や文章でも本物そっくりのフェイクコンテンツを生成する技術が進み、海外ではニセ音声を詐欺に悪用する事例も出ています。こうしたフェイクメディアを検知し被害を未然に防ぐための国の研究プロジェクトも12月に始まりました。

警視庁や京都府警などは10月、芸能人らの顔を合成したポルノ動画をインターネットに投稿した男3人を名誉毀損と著作権法違反の容疑で摘発しました。ディープフェイク動画の摘発は国内では初めてです。500本を超える動画が投稿され、被害にあった芸能人は延べ約150人に上るとされます。

こうしたフェイク動画生成にはディープラーニング(深層学習)と呼ばれるAI技術が使われており、人物の顔の部分を有名人のものに入れ替えたり、動画中で発言している有名人の口の動きを操作して別のことをしゃべっているように見せたりするなど、いくつかのパターンがあります。

最新の技術では人物の顔写真1枚あるだけで、その人物が話している様子を生成できます。まだ画質が粗いものの、有名な経営者がビデオ会議の画面に登場して発言するフェイク映像も実験的に作られています。

問題になっているのは映像だけではありません。ニセの音声はフェイク映像を作るのと似た技術で生成できます。また人間が書いた文章と見分けがつかないほどの自然な文章を、米研究機関が開発した「GPT」と呼ばれる言語モデルを使うことで生成できるようになりました。こうした映像以外の偽コンテンツも最近はディープフェイクと呼ばれるようになりました。

企業幹部に成りすました音声で送金を指示する電話がかかってきて、金をだまし取られるという事件が昨年欧州で起きました。人間そっくりの文章を大量に作れるAIは、デマやフェイクニュースを故意に拡散する手段に使われる恐れがあります。

「本物そっくり」のデジタルコンテンツを作る技術は、往年の歌手の姿を現在のステージによみがえらせるといった演出など、文化や芸術、ビジネスにも応用できる半面、悪用された場合のリスクが大きくなっています。政府は偽映像やフェイクニュースなどを検知し被害を防止するための研究プロジェクトを5年半にわたって進めます。同プロジェクトを統括する越前功・国立情報学研究所教授は「フェイクメディアによる被害が本格化する前に手を打つ必要がある」と話しています。

越前功・国立情報学研究所教授「偽情報の氾濫は大きな脅威」

ディープフェイクなどの技術がどこまで進み、社会にどんな影響が出ているのか。この問題に詳しい越前功・国立情報学研究所教授に聞きました。越前教授はディープフェイク映像の検知技術を世界に先駆けて開発したことで知られ、12月から始まった国の研究プロジェクト「インフォデミックを克服するソーシャル情報基盤技術」の研究代表者を務めています。

――ディープフェイクなどの最近の状況をどうみていますか。

「フェイクはビデオ映像や画像だけでなく、有名人の声をまねて合成した音声や、人が書いたものと区別がつかない文章などでも問題になっています。これらを我々はフェイクメディアと呼んでいます。偽造写真を使って人をだますなどの手口は昔からあったのですが、人が気付かないほど『そっくり』の顔や姿や音声、発言がデジタルメディアとして流通するようになったのが特徴です」

「昨年、英国の民間調査機関が実験的に制作した、ジョンソン首相と野党党首が登場する討論動画が話題になりました。政治的に対立しているはずの2人が弁論を駆使していかに相手が次期首相にふさわしいかを論じ合うというありえないシナリオなのですが、2人の顔は本人そのままで、話し方や使う言葉の癖も似せてあるので、見ている側は引き込まれてしまいます」

「こうした手の込んだフェイク映像を、専門的な知識がない人でもちょっと勉強すれば作れるようになっています。さらにスマートフォンやSNS(交流サイト)の普及で、こういしたコンテンツを容易に発信したり共有したりできるようになり、フェイク拡散のリスクが高まっています」

――映像だけでなく言葉を使ったフェイクニュースにも注意が必要ですね。

「米国の人工知能(AI)研究機関であるOpenAIが開発した『GPT』という言語モデルを使うと、人間が書いたような自然な文章を大量に生成することができます。私もこれを使って商品サイトのフェイクレビューのサンプルをたくさん作り、人によって書かれたレビューと比べて、フェイクを検知する研究を進めています」

「米ワシントン大学とアレン人工知能研究所は共同で、フェイクニュースを自動的に生成できるGrover(グローバー)というAIモデルを開発しました。ニュース原稿などのデータをAIに学習させて、ニュース記事に特有の表現や文体を覚えさせます。フェイク映像生成に使われる敵対的生成ネットワークというディープラーニング(深層学習)技術がここでも使われています」

「新型コロナウイルス感染症が拡大する中で、感染状況や治療法に関する不確かな情報が拡散する『インフォデミック』が問題になりました。こうしたニセ情報やフェイクニュースが、先ほどの英国のビデオのように映像も巧妙に組み合わされて流されることで、人々が惑わされたり、世論が操作されたりする危険があります。ディープフェイクを使って偽のポルノ映像が流されることなどが今問題になっていますが、今後は様々なフェイクメディアが巧妙に利用されて生み出されるインフォデミックが大きな脅威になると考えられます」

――フェイクメディア対策の研究プロジェクトでは何を研究するのですか。

「研究対象として3タイプのフェイクメディアを想定しています。本物に限りなく近いが本物ではない『メディアクローン型』、世論操作などを目的に意図的に編集・生成される『プロパガンダ型』、そして人間には識別困難だがAIを誤動作・誤判定させてしまう『敵対的サンプル型』です。社会科学を含め様々な専門の研究者が参加して4つの分野で研究を進める計画です」

「高度なフェイクメディアを生成する技術の研究から始めます。フェイクメディアへの対策をとるには、まず生成技術を確立する必要があります。顔や身体などの映像、音声、文書など多様なメディアについて研究します。2番目がフェイクメディアに対抗する検知・防御技術の開発です。単にフェイクかどうかを判断するだけではなく、どのような意図でフェイクが作られたかを説明可能な形で示します」

「3番目はフェイクメディアを『無毒化』する技術の開発です。機械学習AIが誤動作したりしないよう、学習データを偏りのないものにすることなどを考えています。4番目が『インフォデミックを緩和し多様な意思決定を支援する情報技術』の開発です。フェイクメディアの生成・検知技術や無毒化技術をいかし、人々が偏りのない意思決定ができる社会の仕組みを研究します」

――人々が偏った意思決定をしないよう、どのような手段を使うのですか。

「難しい課題です。閉鎖的な情報空間でコミュニケーションを繰り返すことで偏った考え方が強まるエコーチェンバーという現象が知られています。これを防ぐには、判断材料となる情報を幅広く受け手に与えるのがポイントではないかと考えています。フェイクらしい情報があるとき、その可能性を教えてあげたり、あるいは異なる見方にたつ情報を同時に提示してあげたりするわけです。最終的に判断するのは人間ですが、様々な情報に接する機会を意図的に作ることでエコーチェンバーを避けられると思います」

「また、ツイッターのようなSNSでは反射的にリツイートをしがちですが、一定時間が過ぎないとリツイートできないような仕組みを取り入れて、SNSユーザーに熟慮する時間を与えるというアイデアもあります。プロジェクトでは1000人規模くらいの実験用SNSを構築して、行動実験をすることも考えています」

(編集委員 吉川和輝)

ワークスタイルや暮らし・家計管理に役立つノウハウなどをまとめています。

※ NIKKEI STYLE は2023年にリニューアルしました。これまでに公開したコンテンツのほとんどは日経電子版などで引き続きご覧いただけます。